《机器学习》 第七章 贝叶斯分类器

第七章 贝叶斯分类器

7.1 贝叶斯决策论

对于N种可能的类别标记,$\lambda_{ij}$是将真实样本cj作物分类为ci产生的损失。基于后验概率可以计算将样本分类为ci的期望损失,即在样本x上的条件风险。

上述公式的意思就是:一个样本来了,对于每一类都有一个概率,对样本x计算错分成其他类别的概率再乘以损失,得到总的损失。就是条件风险

而我们要做的就是找到一个判定准则,使得总体风险最小。

如果对于每一个样本都能够最小化风险R,那么总体的风险就将被最小化。

这就是贝叶斯判定准则:为最小化总体风险,只需要对每个样本选择那个能够使条件风险最小化的类别标记。

此时,h(x)被称作是贝叶斯最优分类器,与之对应的R是贝叶斯风险。

问题:如何求后验概率

具体来说,对于每个样本,选择使得后验概率$P(c|x)$最大的类别标记即可。

但是现实任务中很难直接获得。主要有两种策略:

1、给定x,直接建模$P(c|x)$来预测c,这样得到的是判别式模型。前面的决策树、神经网络、SVM都是这类。

2、先对联合概率密度建模$P(x,c)$,然后再获得$P(c|x)$,这样是生成式模型。

贝叶斯定理求解

根据贝叶斯定理,后验概率可以改写为:

其中$P(c)$是类的“先验概率”;

$P(x|c)$是样本x相对于标记c的类条件概率,也被称作是似然。(也就是在好瓜中,声音清脆的比例,等等)

$P(x)$是由于归一化的“证据”因子,对于给定样本x,证据因子与类别标记无关。

因此求解后验概率就变成了求解先验概率和类条件概率。

1、对于先验概率:表达了样本空间中每类样本所占的比例,根据大数定律,可以根据各类样本所占的比例来估计。

2、对于类条件概率:由于涉及到样本x的所有属性的联合概率,直接按频率估计会有比较大的困难,因为很多样本根本没有出现,比如n维2值属性,样本空间就有2的n次方,样本数往往达不到,因此用频率估计会有很大的问题。不用因为没有观测到,就认为出现的概率为0。

7.2 极大似然估计

对于估计类条件概率,常用的策略是先假设分布形式,再根据样本来估计参数。这就是数理统计中的参数估计部分的内容。

有两个学派:

1、频率主义学派:认为参数未知,但是是固定值,可以通过矩估计、最大似然估计等计算。

2、贝叶斯学派,认为参数是一个随机变量,也符合一个分布,先假设服从一个先验分布,再根据观测的数据计算参数的后验分布。

本节介绍最大似然估计

核心思想是:如果一个事件发生了,哪个假设(参数)能 使得事件发生的概率最大,我们就选择哪个假设(参数)。

比如:猎人和萌新去打猎,兔子被打死了,是谁打的呢?猎人打中的概率明显高于新手,我们可以认为是猎人干的。

例子2:从符合正态分布的总体(均值未知)中取出许多个点,每个点都有一个概率公式,我们让所有点的概率公式连乘,就可以认为是这抽取一批样本联合概率。

这种方法较为简单,但是非常依赖假设的概率分布是否接近潜在真实分布

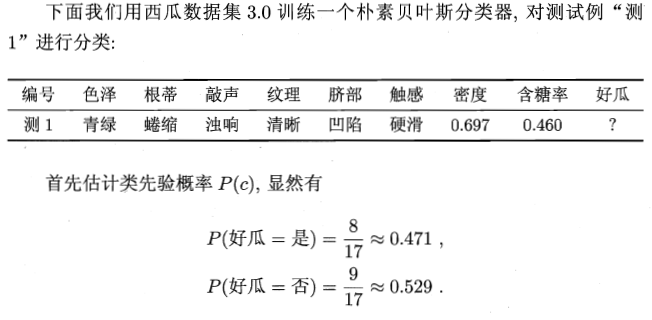

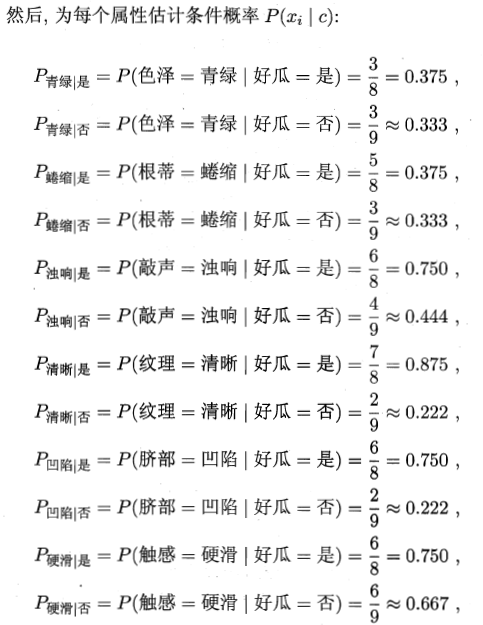

7.3 朴素贝叶斯分类器

从第一节中可以看到,估计后验概率的主要困难在于:类条件概率是在所有属性上的联合概率,难以从有限样本中估计。

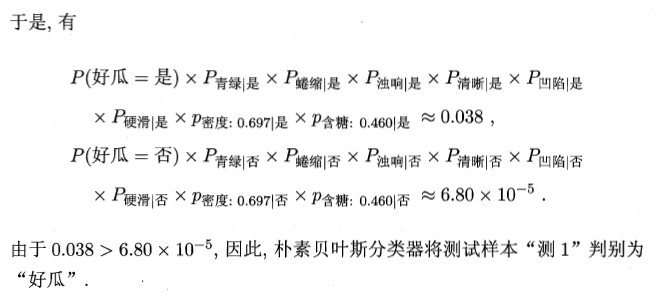

朴素贝叶斯分类器采用了“属性条件独立性假设”,也就是所有属性相互独立。后验概率重写为:

具体来说,将原来的n维互相影响的随机变量变成n维独立地随机变量,然后分解成n个简单的概率。

这里可能有个小问题,如果某个属性的样本数为0,那么连乘之后的概率还是0,不太合理,需要平滑数据。

7.4 半朴素贝叶斯分类器

前一节中,为了降低贝叶斯公式中后验概率的估计,采用了属性独立性假设,但是现实任务中较难成立,于是把条件适当放松,允许一部分属性相互依赖,半朴素贝叶斯分类器允许每个属性最多依赖一个其他属性。

计算方法【略】

7.5 贝叶斯网

借助有向无环图(DAG图)来刻画属性之间的依赖关系。

7.6 EM算法

前面的算法假设所有属性都能直接被观测到,但是现实中不是这样,比如西瓜的根蒂有时会脱落,无法得知。

但是我们可以假设无法观测到的属性值为隐变量,而EM算法就是估计隐变量的好方法。

基本思想是:如果分布的参数已知,则可以根据训练数据推断出最优隐变量的值;反之,如果隐变量的值已知,则可以方便地估计参数。

算法步骤:

1、E步:先初始化一个分布的参数值,利用这个参数值来计算对数似然的期望值,来估计隐变量;

2、M步:利用E步得到的隐变量,来估计心得参数值

这么循环,直至收敛至最优解。